Your browser doesn’t support HTML5 audio

¿Qué es V-JEPA 2 y por qué importa?

V-JEPA 2 es un modelo de inteligencia artificial desarrollado por Meta FAIR (el equipo de investigación de Meta, antes Facebook) que se entrena con millones de videos para entender lo que sucede en ellos, predecir lo que va a pasar y hasta planificar acciones basadas en esa comprensión.

¿Por qué es relevante? Porque la mayoría de los modelos actuales de IA en video necesitan mucha supervisión humana: alguien les tiene que decir qué es cada cosa.

V-JEPA 2, en cambio, usa un método llamado auto-supervisión, que significa que aprende solo, sin etiquetas ni instrucciones, a partir de la información que encuentra en los videos.

Esto permite que la máquina desarrolle una especie de “sentido común visual” para entender movimientos humanos, anticipar acciones y hasta controlar robots para tareas como agarrar objetos o mover cosas sin haber sido entrenada específicamente para esos entornos.

Puedes descargar el modelo desde aquí.

Cómo funciona V-JEPA 2

- Aprendizaje auto-supervisado con videos naturales:

El modelo analiza videos reales (por ejemplo, videos en internet) y trata de predecir partes ocultas de esos videos, como si completara un rompecabezas en base a lo que ve. Así aprende sobre movimiento, objetos y relaciones en el mundo real sin ayuda humana. - Encoder y predictor:

- El encoder convierte las imágenes y movimientos en datos comprensibles para la máquina.

- El predictor usa esos datos para imaginar qué va a pasar después.

- Post-entrenamiento para tareas específicas:

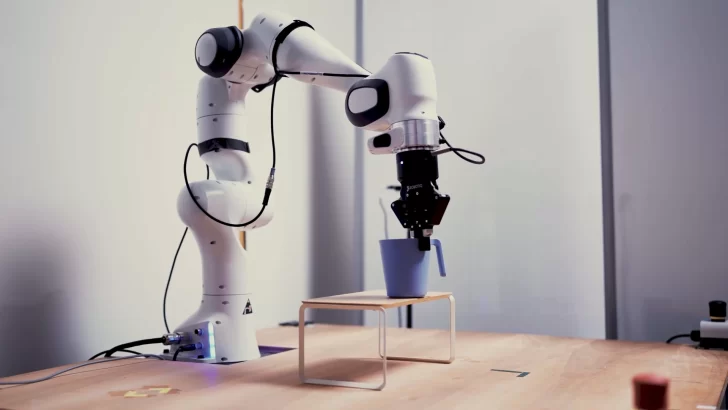

Por ejemplo, con un poco de datos de robots, V-JEPA 2 se ajusta para controlar brazos robóticos, logrando que hagan tareas prácticas como alcanzar, agarrar y mover objetos sin haber sido entrenado para un entorno específico.

¿Qué puede hacer V-JEPA 2 hoy?

- Entender acciones humanas: Reconoce movimientos y gestos con precisión superior a modelos anteriores.

- Predecir el próximo movimiento: Puede anticipar qué hará una persona segundos después en un video.

- Controlar robots: Usando solo imágenes de cámaras, puede guiar un brazo robótico para manipular objetos (como agarrar una taza o mover una caja), incluso en entornos nuevos sin calibración previa.

Cómo empezar a usar V-JEPA 2 (de forma sencilla)

Si tienes interés en probar o usar este modelo, aquí un resumen básico para hacerlo con herramientas comunes:

- Preparar el entorno:

Necesitas instalar Python 3.12 y algunas librerías para IA (como PyTorch). Se recomienda una computadora con GPU para procesar videos rápido. - Instalar V-JEPA 2:

Puedes instalar el paquete oficial conpip install .(desde el código oficial de Meta) o usar los modelos ya entrenados disponibles en HuggingFace. - Cargar el modelo:

Usando código Python, cargas el modelo preentrenado y un preprocesador para preparar los videos para la IA. - Ejecutar una prueba:

Carga un video de ejemplo, pásalo al modelo y obtén resultados como la clasificación de acciones o predicciones.

Aplicaciones futuras y el impacto

- Robótica: Mejorar la capacidad de los robots para trabajar en ambientes reales sin necesidad de reentrenamiento constante.

- Seguridad y vigilancia: Detectar comportamientos anómalos o anticipar eventos antes de que ocurran.

- Videoanálisis para deportes y salud: Comprender movimientos y prever lesiones o acciones en tiempo real.

- Asistentes digitales: Que entiendan mejor lo que sucede en videos o cámaras para ayudar en tareas cotidianas.

Noticias relacionadas